Интернет-портал интеллектуальной молодёжи

http://ipim.ru/discussion/1964.html (версия для печати)

|

|

Если тебе "академия" имя…

07 апреля 2011 17:42

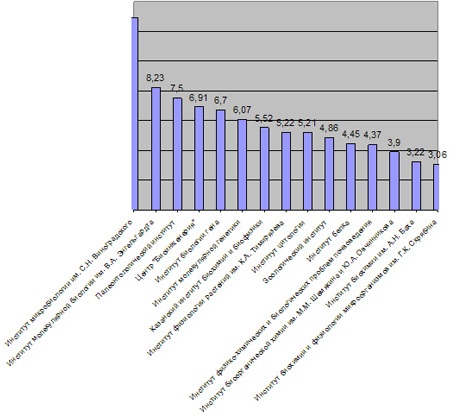

Среднее количество публикаций на одного научного сотрудника института с 1990 по 2011 год (по базе Web of Science). Иллюстрация с сайта www.strf.ru Российская академия наук приступает к оценке результативности институтов по методике, в которой учитываются более сотни критериев. Скорее, это будет полный аудит фундаментальной науки, который, безусловно, полезен и даже необходим, но по его итогам вряд ли удастся понять главное: к каким результатам должно стремиться "чистое знание". В то же время в академических кругах параллельно официальной родилась ещё одна методика оценки, с помощью которой можно быстро вычислить, кто чего стоит в академической науке. Подробности – в материале STRF.ru.

Диагноз науки

Начиная с этого года, каждое научное учреждение в структуре РАН будет подвергаться всесторонней оценке, а общие итоги результативности академии будут подводиться, как в добрые советские времена, раз в пятилетку. Напомним, инициатива этой своеобразной формальной экспертизы принадлежит Минобрнауки, которое в 2009 году утвердило типовую методику оценки результативности научных организаций, выполняющих исследования гражданского назначения. Это, конечно, спровоцировало бурю негодования в среде учёных, но, как говорится, закон есть закон: РАН стала готовиться к исполнению распоряжения, расширив и без того путаную типовую методику до почти сотни критериев и сделав её таким образом всеобъемлющей. По ней теперь можно провести полный аудит академической науки, но понять, в чём же состоит главный научный результат, крайне сложно.

В оценке, например, будут учитываться наиболее перспективные темы исследований по каждому записанному за институтом направлению; количество признанных научных школ; количество сотрудников, участвующих в экспертизах международных научно-технических проектов; число публикаций на одного исследователя в зарубежных изданиях и российских ВАКовских журналах; количество информационно-аналитических докладов и справок для органов госвласти; объём средств, поступивших от передачи технологий; число молодых специалистов, принятых на работу в отчётном году; наличие уникальных научных стендов; доля доходов от сдачи помещений в аренду и многое другое.

Те показатели, которые можно формализовать, например, по состоянию материально-финансовой базы, кадровому составу, публикационной активности, будут заноситься в специально разработанную автоматизированную таблицу, которая приведёт их к нужному знаменателю. Остальные, в частности перспективность направлений исследований, актуальность выбранных тем, условия труда и некоторые другие, будет оценивать комиссия из ведущих специалистов, компетентных в соответствующих областях науки. Работы, мягко выражаясь, немало. По словам учёного секретаря комиссии по оценке результативности деятельности научных организаций РАН Андрея Кулагина, за один год таким образом можно проверить 80–90 институтов, а полный цикл оценки будет проведён за пять лет. Помимо временных, предстоят и материальные, и чисто трудовые затраты. В отделениях академии будут проводиться обучающие семинары по внедрению методики, в каждый институт приедут члены экспертной комиссии, которым также потребуются деньги на организацию работы в чужих краях. Кстати, именно экспертная комиссия, опираясь на предоставленные институтом, а после проверенные ей самой цифры, а также на собственное мнение, вынесет окончательный вердикт в отношении научного учреждения – к какой из трёх категорий его отнести: организациям-лидерам; стабильным организациям, демонстрирующим удовлетворительную результативность; или организациям, утратившим научный профиль и перспективы развития.

Какие меры будут предприняты по результатам такого ранжирования, решит Президиум РАН. "Тут могут быть разные ситуации, – поясняет Андрей Кулагин. – Первая: мы вынесли негативную оценку, установив, что причина неэффективности института в том, что ему давали недостаточно денег на оборудование. Мы считаем, что с институтом ничего особенного делать не надо, его просто нужно немножко подкормить. Комиссия по эффективности соглашается с такой постановкой вопроса, и он выносится на президиум, где принимается решение – дать или не дать денег. Если же несколько институтов одного профиля получили самую высокую оценку, необходимо будет выяснить, работают ли они как система. Но я сейчас привожу очень условные примеры. Дело комиссии – поставить правильный диагноз, а выписывать рецепт, лечить уже будет Президиум РАН".

Первые десятки институтов начали вносить показатели в таблицу уже в марте; первые оценки комиссии будут известны в июне-июле, после чего в академии должны начаться настоящие преобразования.

Протестное голосование

Цель всей этой затеи, замечает Андрей Кулагин, – сформировать максимально полную и объективную картину результативности академии наук. Удастся ли это сделать описанными выше способами – вопрос как минимум дискуссионный, полагают в академических институтах. При этом основные сомнения связаны не с методикой, а с самим фактом неизбежности формальной оценки, который в научном сообществе, несмотря на долгие дискуссии, ещё не принимается как должное.

"Система баллов довольно грубо измеряет результаты, – делится соображениями по этому поводу директор Института высокомолекулярных соединений РАН Евгений Панарин. – Она не учитывает того, что в академическом институте, как правило, большая часть исследований проводится на дальнюю перспективу. В частности, наш институт занимается исследованиями в области биомедицинских материалов, полимеров. Нам нужно потратить не один десяток лет, прежде чем мы получим лекарственный препарат, который можно запустить в производство. Таким образом, при оценке деятельности института за короткий промежуток времени этого результата никто не увидит. Мне кажется, что предложенная методика – это прокрустово ложе для академии. Для объективного рейтинга всё же больше подходит экспертная оценка".

За экспертизу "голосует" и директор Научного центра волоконной оптики РАН Евгений Дианов, который, правда, считает, что оценку научных результатов РАН нужно проводить совместными усилиями как представителей академии, так и вузовского сообщества и зарубежной науки. В разработанной РАН методике, которая, по мнению Дианова, всё же имеет право на апробирование, не хватает такого критерия, как количество "приглашённых докладов" на крупных международных конференциях. "Это не просто участие в конференции, когда человек платит оргвзнос и едет выступить с обычным докладом и послушать выступления коллег, – поясняет он. – Это когда из всех специалистов по конкретной тематике организаторы самых серьёзных научных мероприятий приглашают выступить с докладом именно представителей данного института. Такие доклады ещё вернее, чем статьи в авторитетных журналах, показывают научный уровень института на международной арене. Но эта характеристика, к сожалению, ни в каких оценках сейчас не учитывается".

Ещё один академик, которого удалось заинтересовать вопросами о грядущей оценке результативности академических институтов, директор Института белка РАН Лев Овчинников, ответил, что главным может быть только один критерий – публикации в журналах с высоким импакт-фактором и что в целом рейтингование институтов по предлагаемой методике принесёт больше вреда, чем пользы. "Это потеря времени на всякие бюрократические вещи, потому что мы прекрасно знаем друг друга без всяких расчётов, – уверен Овчинников. – У меня впечатление, что

чиновники хотят иметь очень простой алгоритм, по которому будут руководить наукой. Но на практике получат они циферки, выяснят, что один институт результативнее другого в десять раз – и что?

Значит, к примеру, геологию нефти нужно развивать, а геологию урановых руд – нет? Выводы делать на основании этих цифр всё равно очень трудно. И, конечно, чиновники эти выводы делать не могут".

Впрочем, вне зависимости от накала споров все институты готовятся к формальной оценке собственной результативности, а академия – к наведению нового порядка в собственной системе. Правда, как должен выглядеть этот новый порядок, представить пока довольно сложно.

Мировой уровень

В то же время в академических кругах параллельно официальной родилась ещё одна методика оценки, по которой можно быстро понять, какие институты чего стоят, что, собственно, от них требуется и к чему должна стремиться Российская академия наук как структура, ответственная за развитие фундаментальной науки. Её инициатор, директор Лимнологического института Сибирского отделения РАН, академик Михаил Грачёв, убеждён в том, что академические учреждения должны заниматься прежде всего наукой, и, исходя именно из этого посыла, нужно выводить оценку их результативности – то есть устанавливать, вписываются ли научные результаты этих организаций в систему мировой науки.

"Институт может делать замечательные работы для самого Медведева или Путина, писать великолепные отчёты, привлекать десятки молодых учёных, давать экономию и всё что угодно, но если его научные результаты не имеют связи с мировым уровнем, то это не академический институт, – поясняет Грачёв. – Как писал Владимир Маяковский, “если тебе “корова” имя, у тебя должны быть молоко и вымя. А если ты без молока и без вымени, то черта ль в твоём коровьем имени!” Так и здесь: результатом деятельности фундаментальной науки должны быть публикации в получивших мировое признание журналах и в конечном итоге тот факт, что эти публикации начинают цитироваться".

Результат, по мнению Грачёва, должен рассчитываться в удельном выражении и представлять собой среднее количество статей на одного штатного научного сотрудника за определённый период. Вычислять его академик предлагает, используя поисковую систему базы Web of Science (WoS). Тогда как в академической методике для расчёта публикационной активности речь идёт о "ручном инструментарие": институты должны получить сведения от сотрудников о наличии статей в журналах, входящих в базу международного цитирования, и передать их в комиссию, а комиссия затем проверит. "Такая организация нерациональна, потому что институты, во-первых, не хотят этим заниматься, во-вторых, делают массу ошибок, – замечает академик Грачёв. – Проще и эффективнее в поиске WoS набрать название организации на английском во всех возможных вариантах, избегая, конечно, “окровавленных белочек” (“squirrel institute”). По запросам база выдаст и количество публикаций с адресом заданного института, и количество ссылок на публикации института".

За две с лишним недели Михаил Грачёв с небольшой группой учёных, разделяющих его позицию по методике подсчёта научной результативности, просканировал таким образом 77 организаций Сибирского отделения РАН (такую "проверку", в отличие от официальной академической, оказалось возможным провести малыми силами и дистанционно, не расходуя на неё бюджетные миллионы и большое количество времени). Полученная информация была разослана в институты, откуда инициативной группе прислали свои подсчёты. Как правило, цифры, полученные в автоматическом и ручном режимах, совпадали, однако было несколько случаев, когда институты, считая вручную статьи, "обижали" себя на 100 и более публикаций. В итоге с каждой организацией всё же был достигнут компромисс по окончательной цифре, отражающей количество публикаций, и статейные показатели каждого института были поделены на количество работающих в нём сотрудников.

В методах подсчёта числа учёных, кстати, тоже принципиальное отличие рождённой в Сибири методики от официально утверждённой. РАН предлагает опираться на количество исследователей, то есть на довольно условную величину, в которую входят и аспиранты-практиканты, и учёные-контрактники; сибиряки же берут во внимание только работающих в организациях научных сотрудников. Статистику Михаил Грачёв собирал с 1980 года (РАН затрагивает последние пять лет), чтобы получить наиболее полную информацию о цитируемости статей (публикации, появившиеся в журналах недавно, просто не успевают набрать приличного индекса цитируемости).

Результаты этих нехитрых манипуляций получились весьма интересными: оказалось, что

третья часть институтов Сибирского отделения РАН даёт 80–90 процентов научной продукции, ещё одна треть – 5–10 процентов и остальные – менее одного процента.

Вопрос о том, что делать с этим рейтингом, непростой. По мнению академика Грачёва, слабые институты можно укрепить сильными коллективами, так же как отстающие футбольные команды укрепляют сильными игроками; в особо тяжёлых случаях можно принять и радикальное решение о расформировании организаций. "Недопустимо, чтобы за длительные промежутки не только отдельные люди, но и целые институты не выдавали цитирований, – говорит Грачёв. – И соответственно финансирование организаций, как сейчас – пропорционально численности работающих в них сотрудников с небольшими поправками на коэффициенты – распределять нерационально. Но, конечно, прежде чем предпринимать какие-либо меры, полученные результаты нужно как следует проанализировать и действовать уже с расчётом на конкретный результат".

Наши расчёты

Предоставить результаты своих подсчётов Михаил Грачёв, увы, отказался, мотивировав это нежеланием настраивать против себя немалую часть научного сообщества. И тогда ваш покорный слуга, лишённый подобного рода предубеждений, в надежде получить хоть какие-то опорные цифры сделал похожую работу самостоятельно – по предложенной методике рассчитал среднее количество публикаций в журналах, входящих в базу WoS, на одного научного сотрудника института за истекшие 20 лет (я взяла период с 1990 по 2011 год, так как некоторые организации появились только в 1990 году). Конечно, не для всей академии – это было бы слишком трудоёмко для обычной иллюстрации, а для Отделения биологических наук РАН, которое принято считать самым плодовитым в плане публикаций. Вот что из этого получилось.

Что из всего этого следует, думайте сами. Ещё раз отмечу вслед за сибирским академиком: не стоит в сухой статистике усматривать призыв к закрытию целых научных направлений, курируемых не самыми продуктивными институтами, это было бы грубой ошибкой. Размышления о том, что долгое время отечественная наука была устроена так, что от учёного не требовалось публиковаться в зарубежных журналах, уверяю, никому не чужды. Все понимают, что многие исследователи, начинавшие профессиональную деятельность в закрытой от внешнего мира советской науке, в силу разных причин просто не смогли подстроиться под новые правила игры; что какой-то директор не смог в своё время отстоять нужные объёмы финансирования или добиться приобретения необходимых для передовых исследований приборов. Однако все эти аргументы сейчас уже носят, скорее, философский характер и не могут служить основанием для дальнейшей поддержки неэффективных подходов к управлению фундаментальной наукой, если, конечно, те, кто ответствен за этот процесс, хотят, чтобы российская наука развивалась.

Быкова Наталья

источник: